Join getAbstract to access the summary!

Join getAbstract to access the summary!

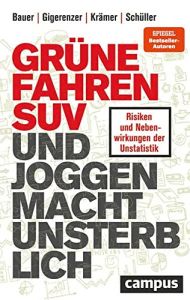

Katharina Schüller, Thomas Bauer, Gerd Gigerenzer und Walter Krämer

Grüne fahren SUV und Joggen macht unsterblich

Über Risiken und Nebenwirkungen der Unstatistik

Campus, 2022

What's inside?

Warum viele in den Medien kursierende Statistiken purer Unsinn sind – und wie Sie das erkennen.

Rezension

Artikel-Überschriften wie „Grünen-Wähler fahren gerne SUV“ sind beliebt. Allerdings basieren sie oft auf unzureichenden Studien und Umfragen oder falsch interpretierten Zahlen. Die Autoren dieses Buches vermitteln statistische Grundlagen und öffnen den Blick für solche Fallen – und das extrem gut. Dabei ist das Buch keinesfalls trocken, sondern, im Gegenteil, ein richtiger Schmöker und regt zum Mitdenken ein. Es sensibilisiert dafür, Zahlen stärker zu hinterfragen. Eine Fähigkeit, die in Zeiten kurzer Aufmerksamkeitsspannen und allgegenwärtiger Fake News wichtiger ist denn je.

Take-aways

- Es mangelt in Deutschland an statistischem Wissen, daher fallen wir immer wieder auf fehlerhafte Statistiken herein.

- Nur weil Daten miteinander korrelieren, heißt das noch lange nicht, dass eine Kausalität vorliegt.

- Ausgerufene Trends basieren oft auf fehlerhaften Daten oder falschen Interpretationen, Umfragen sind häufig nicht repräsentativ.

- Datenschaubilder können ebenso trügen wie die reinen Zahlen.

- Mit statistischem Wissen lässt sich auch erkennen, wo Panik fehl am Platz ist.

- Aus Angst vor einem Risiko ändern wir unser Verhalten und gehen dabei unter Umständen deutlich größere Risiken ein.

- Fünf Grundprinzipien statistischen Denkens sollte jeder kennen, etwa den Unterschied von relativem und absolutem Risiko.

- In Schulen muss Statistik deutlich intensiver und lebensnäher unterrichtet werden.

Zusammenfassung

Es mangelt in Deutschland an statistischem Wissen, daher fallen wir immer wieder auf fehlerhafte Statistiken herein.

Statistiken verstehen und richtig interpretieren – das fällt den meisten Menschen schwer. Artikel mit Überschriften wie „Grünen-Wähler fahren gerne SUV“ oder „Jede Stunde Joggen schenkt dir sieben Stunden Lebenszeit“ werden gern gelesen. Sie basieren aber oft auf Umfragen oder Studien, die wissenschaftlichen Ansprüchen nicht genügen. Oder sie werden von Journalisten falsch interpretiert. Erkennen kann das kaum jemand.

„Unser Verhältnis zu Zahlen ist immer noch ‚posttraumatisch gestört‘. Das Trauma begann für viele wohl im Mathematikunterricht in der Schule.“

Es herrscht ein Analphabetismus im Umgang mit Zahlen, Wahrscheinlichkeiten und Risiken. Dabei sind Statistiken enorm wichtig, in der Medizin natürlich, aber auch als Grundlage für politische Entscheidungen. Die Folge dieser Zahlenblindheit ist zum Beispiel, dass Krebs-Screenings unkritisch empfohlen werden. Medizinische Tests werden falsch eingeschätzt. Und der „Equal Pay Day“ wird am falschen Tag gefeiert. Es ist höchste Zeit, einige Grundlagen des statistischen Denkens zu erlernen.

Nur weil Daten miteinander korrelieren, heißt das noch lange nicht, dass eine Kausalität vorliegt.

Der Klassiker unter den Fehlern im Umgang mit Zahlen ist das Verwechseln von Korrelation und Kausalität. Von einer positiven Korrelation spricht man, wenn zwei Größen oder Datenreihen systematisch in dieselbe Richtung laufen – und zwar im Allgemeinen, nicht in jedem einzelnen Fall. Von einer negativen Korrelation spricht man, wenn sie in die entgegengesetzte Richtung laufen. Kausalität bedeutet hingegen, dass das eine aus dem anderen folgt.

„Längst nicht jeder Korrelation liegt eine Kausalbeziehung zugrunde. Die Frage, wann man berechtigterweise von Kausalität sprechen kann, ist eine der kniffligsten in der ganzen empirischen Statistik überhaupt.“

Es gibt offenbar eine hohe negative Korrelation zwischen dem Bestand an Regenwald weltweit und dem Vorkommen von tierbasierten Infektionskrankheiten à la Corona, wie französische Biomediziner 2021 berichteten. „Waldrodung begünstigt Tierkrankheiten“, wie der Schweizer Blick meldete, lässt sich daraus aber nicht schließen. Korrelationen ohne kausalen Hintergrund werden auch „Scheinkorrelationen“ oder „Nonsenskorrelationen“ genannt. Der Zusammenhang von Schuhgröße und Intelligenz bei Jugendlichen ist eine solche Nonsenskorrelation: Eine größere Schuhgröße korreliert mit einem besseren Ergebnis beim Intelligenztest. Diese Korrelation ergibt sich durch das Lebensalter. Je älter die Jugendlichen sind, desto größer die Füße und desto besser das Abschneiden bei Intelligenztests.

Oft ist auch unklar, was was beeinflusst. Das gilt zum Beispiel für das Studienergebnis „Wer häufig googelt, riskiert seine Intelligenz“. Für die Studie wurden kanadische Erwachsene zu ihrem Smartphone-Verhalten befragt und mussten außerdem logische Denkaufgaben lösen. Es zeigte sich, dass diejenigen, die viel Zeit mit Suchmaschinen verbrachten, niedrigere Leistungen bei den Denkaufgaben erzielten. Die Daten korrelierten also. Dennoch lässt sich von häufigem Googeln nicht auf sinkende Intelligenz schließen. Vielmehr könnte es auch umgekehrt sein: Weniger Intelligente greifen stärker auf Google zurück.

Ausgerufene Trends basieren oft auf fehlerhaften Daten oder falschen Interpretationen, Umfragen sind häufig nicht repräsentativ.

Passen Sie auf, wenn Trends ausgerufen werden und zum Beweis Zahlen herangezogen werden. Das Bundesgesundheitsministerium meldete 2011 etwa, dass 560 000 Menschen in Deutschland internetsüchtig seien. Weitere 2,5 Millionen wiesen einen problematischen Internetkonsum auf. Hier gibt es zwei Probleme. Das eine ist die Messung: Wie kann Internetsucht überhaupt gemessen werden? Das zweite Problem ist das Hochrechnen kleiner Zahlen. Denn von den insgesamt 15 000 Befragten waren lediglich 250 „onlinesüchtig“. Diese Zahl wurde dann auf die deutsche Gesamtbevölkerung hochgerechnet. In einer Spiegel-Online-Schlagzeile klang das so: „Forscher erklären Hunderttausende für onlinesüchtig.“ Dabei kam diese Zahl in der Studie gar nicht vor.

Auch bei Zeitreihen gilt es aufzupassen. Die Denkfabrik Agora Energiewende meldete etwa für 2021 in Deutschland den höchsten Anstieg der Treibhausgasemissionen seit 1990. Allerdings war es 2020 aufgrund der Coronapandemie zu einem signifikanten CO2-Rückgang gekommen. Der hohe Anstieg 2021 im Vergleich zum Vorjahr ist daher kaum überraschend.

„Vor allem Internetumfragen sind oft alles andere als repräsentativ, vor allem, wenn die Teilnahme freiwillig ist.“

Werden Sie auch hellhörig, wenn es um Umfragen geht. Diese sind oft nicht repräsentativ. Das gilt vor allem für Umfragen, bei denen die Befragten selbst über die Teilnahme entscheiden können. Auch Onlineumfragen sind nie repräsentativ, denn sie wurden nur unter Internetnutzern durchgeführt. Nicht repräsentativ war zum Beispiel die Umfrage, auf der eine Meldung der Frankfurter Allgemeine Sonntagszeitung 2021 basierte: Jeder sechste Grünen-Anhänger habe einen Geländewagen vor der Tür stehen, hieß es. Die Zeitung berief sich auf das Marktforschungsunternehmen Puls. Befragt hatte Puls 1042 Personen, aber nur solche, die angaben, in den nächsten Monaten ein Auto kaufen zu wollen oder in den vergangenen zwölf Monaten ein Auto gekauft zu haben. Menschen, die grundsätzlich auf ein Auto verzichten oder gerade keinen Autokauf getätigt oder geplant haben, wurden in dieser Umfrage gar nicht berücksichtigt. Um ein valides Ergebnis zu erhalten, hätten auch deren Parteipräferenzen erhoben werden müssen.

Datenschaubilder können ebenso trügen wie die reinen Zahlen.

Visualisierungen können das Verständnis von Daten enorm erleichtern: Auf einen Blick ist erkennbar, was in Worte gefasst viele Zeilen benötigen würde. Dennoch haben auch Schaubilder ihre Tücken. Sie können Inhalte verfälscht darstellen, gezielt oder auch unbeabsichtigt. Dabei spielt es schon eine Rolle, welche Daten überhaupt berücksichtigt werden und welche nicht.

„Bildliche Darstellungen mögen attraktiv und hochprofessionell daherkommen, können aber den zu vermittelnden Sachverhalt grob verzerren.“

Ein Klassiker der Verfälschung ist, die Achsen zu verkürzen. Fangen die Achsen nicht bei null an, wirken kleine Unterschiede plötzlich immens. Etwa postete der Lindauer Landrat Elmar Stegemann während der Coronazeit auf Facebook stolz die Impfquote seines Landkreises im Vergleich zu der in Gesamtbayern und Gesamtdeutschland. Statt bei 0 Prozent begann die y-Achse in seinem Schaubild allerdings bei 18 Prozent. Dadurch wirkten die 21,7 Prozent in Lindau im Vergleich zu den 19,1 Prozent in Bayern und 19,47 Prozent in Deutschland extrem hoch. Gut zu wissen: Programme wie Excel verkürzen die Achsen automatisch.

Mit statistischem Wissen lässt sich auch erkennen, wo Panik fehl am Platz ist.

Risiken zu erkennen ist wichtig. Immer wieder sorgen wir uns aber auch völlig unbegründet. 2011 löste die Meldung, dass ein Futtermittelhersteller in Schleswig-Holstein einem Futterfett dioxinbelastete Rückstände aus Biodiesel beigemischt hatte, eine Dioxin-Panik aus. Nur einen Monat später stellte sich heraus, dass die Angst völlig ungerechtfertigt war: Die erlaubten Höchstwerte wurden zwar leicht überschritten, echte gesundheitliche Gefahren bestanden aber nicht.

Beliebte Panikmacher sind auch Meldungen zu Stickstoff, Feinstaub und vor allem zu Krebs. Etwa berichtete die Hannoversche Allgemeine Zeitung im Mai 2016 über „Die rätselhaften Krebsfälle von Rodewald“. Verdächtigt wurden Abfallprodukte aus der Erdölförderung. Zwischen 2005 und 2013 seien 20 Einwohner an Leukämie oder Lymphomen erkrankt, normal gewesen wären zwölf Fälle. Diese Häufung war allerdings alles andere als signifikant. Die „normalen“ Werte sind Durchschnitte, das heißt: Es gibt Gemeinden ohne Erkrankte und andere mit vielen Erkrankten. Auch wenn es Gefährdungen dieser Art gibt: Allein aufgrund dieser Zahlen lässt sich nicht darauf schließen, dass die Rodewalder besonders gefährdet wären.

Aus Angst vor einem Risiko ändern wir unser Verhalten und gehen dabei unter Umständen deutlich größere Risiken ein.

Die Angst vor einem Risiko kann, selbst wenn sie unbegründet ist, dazu führen, dass wir uns einem noch größeren Risiko aussetzen. So etwa beim Schlecker-Babykost-Skandal 2013: Damals hatte eine Verbraucherschutzinitiative Rückstände eines Pflanzenschutzmittels in Babybreigläschen der Drogeriekette Schlecker entdeckt – in Deutschland darf Babykost keinerlei Pestizide enthalten. Die Folge war, dass viele Eltern Schlecker boykottierten und den Babybrei selbst herstellten, und zwar mit Gemüse vom Wochenmarkt. Das Problem: Marktgemüse darf in Deutschland eine bis zu 200-mal höhere Schadstoffkonzentration aufweisen, als in den Schlecker-Gläschen jemals nachgewiesen wurde.

Ein anderes Beispiel ist die Panik nach den Terroranschlägen am 11. September 2001 auf das World Trade Center in New York, das Pentagon und einen Linienjet. Aus Angst vor weiteren Anschlägen stiegen damals in den USA viele Menschen auf das Auto um. In dem Jahr nach dem Terroranschlag sind schätzungsweise 1600 Verkehrsteilnehmer mehr gestorben, als ohne Terroranschlag zu erwarten gewesen wäre – das sind sechsmal so viele wie in den vier entführten Flugzeugen.

Fünf Grundprinzipien statistischen Denkens sollte jeder kennen, etwa den Unterschied von relativem und absolutem Risiko.

Sie sollten fünf Grundprinzipien statistischen Denkens immer im Kopf behalten: Seien Sie sich erstens bewusst, dass es keine hundertprozentige Gewissheit gibt. So ist keine Impfung zu 100 Prozent sicher; der Aufschrei nach der Meldung, dass erste Corona-Geimpfte sich dennoch angesteckt hatten und ins Krankenhaus eingeliefert wurden, war also völlig unbegründet. Vergessen Sie auch nicht, dass Daten und die Schlussfolgerungen daraus kein gesichertes Wissen sind. Trotzdem müssen auf der Grundlage solch unsicherer Daten oft Entscheidungen getroffen werden, medizinische, aber auch politische.

„Das Einmaleins der Skepsis beginnt mit der Erkenntnis: Sicherheit ist eine Illusion.“

Fragen Sie zweitens immer nach der Grundgesamtheit, also: Prozent wovon? Oft wird keine oder eine falsche Referenzklasse genannt. Etwa meldete der Konstanzer Südkurier 2016, 73,4 Prozent der SC-Freiburg-Anhänger hätten einen Hochschulabschluss. Die Meldung basierte aber auf einer Umfrage im Berufsnetzwerk Xing. Das wird vor allem von Akademikern genutzt. Die Umfrage war damit also alles andere als repräsentativ.

Verwechseln Sie drittens relative Risiken nicht mit absoluten Risiken. Aus der Aussage, dass bei Personen, die regelmäßig Passivrauchen ausgesetzt sind, das Risiko einer Herzkrankheit um 25 Prozent steigt, lässt sich nicht folgern, dass von je vier Nichtrauchern, die dem Passivrauchen ausgesetzt sind, einer eine Herzkrankheit bekommt. Hier wird der relative Anstieg von 25 Prozent mit einem absoluten Anstieg von 25 Prozentpunkten verwechselt. Wenn von 100 Menschen acht ein Herzleiden bekommen und Passivrauchen zu einem Anstieg von 25 Prozent führt, dann kämen zu den acht nochmal zwei Personen hinzu. Der absolute Anstieg läge also bei 2 und nicht bei 25 Prozentpunkten

Hinterfragen Sie viertens bei medizinischen Tests stets sowohl die Trefferrate als auch die Falsch-Alarm-Rate. Denn medizinische Tests können zweierlei falsche Ergebnisse liefern: falsch-positive und falsch-negative. Falsch-positiv bedeutet, dass der Test auf eine Krankheit zwar positiv ausfällt, die Person aber gesund ist. Falsch-negativ heißt, dass das Ergebnis negativ, die Person aber krank ist. Der Anteil positiver Ergebnisse unter allen gesunden Personen nennt sich Falsch-Alarm-Rate, der Anteil von positiven Ergebnissen unter allen Erkrankten Trefferrate. Für sich genommen sagen beide nichts aus. Ein Beispiel: Eine Partnervermittlung wirbt mit einem Test, der eine Scheidung mit 100 Prozent Trefferrate vorhersagt. Das bedeutet aber nur, dass der Test jede tatsächliche Scheidung auch vorhergesagt hat. Sagt der Test nämlich einfach bei jedem Paar eine Scheidung vorher, hat er neben der 100 Prozent Trefferrate auch eine Falsch-Alarm-Rate von 100 Prozent. Wichtiger ist deshalb der „positive Vorhersagewert“, der neben den beiden genannten Raten auch die Grundrate berücksichtigt. Der positive Vorhersagewert benennt zum Beispiel die Wahrscheinlichkeit, dass Sie wirklich mit HIV infiziert sind, wenn Sie einen positiven Test erhalten haben.

Behalten Sie fünftens die Grundrate im Auge. In der Coronapandemie machte eine Grafik Furore: Diese zeigte, dass 91 Prozent der über Sechzigjährigen gegen Covid-19 geimpft waren, 9 Prozent nicht. Dennoch war über die Hälfte der Infizierten geimpft und 43 Prozent der mit Covid-19 Verstorbenen ebenfalls. Das löste – etwa in einer Markus-Lanz-Talkshow – große Empörung aus. Allerdings: Aus den Zahlen lässt sich keineswegs schließen, dass die Impfung nicht vor Infektion schützt. Denn die Grundrate ist im ersten Fall die Bevölkerung insgesamt, in den anderen Fällen hingegen sind es die Infizierten und die mit Covid Verstorbenen. Ein Beispiel macht das deutlich: Wären alle im Alter ab 60 Jahren geimpft, wären unter den Infizierten nur noch Geimpfte zu finden.

In Schulen muss Statistik deutlich intensiver und lebensnäher unterrichtet werden.

Die Zahlenblindheit kommt nicht von ungefähr. Sie ist vielmehr Folge fehlender Ausbildung. In Schulen wird Algebra, Geometrie und Trigonometrie unterrichtet, aber kaum Statistik und Wahrscheinlichkeitsrechnung. Das war im Übrigen auch der Grund für das schlechte Abschneiden im PISA-Mathematiktest 2003. Denn ein Viertel der Fragen kam genau aus diesen Bereichen.

„Das korrekte Interpretieren von Zahlen und Statistiken ist im Land der Dichter und Denker noch immer kein Teil der Allgemeinbildung.“

Doch sollte Statistik nicht nur im Fach Mathematik unterrichtet werden und nicht nur anhand von Zahlen. Denn das könnte den Eindruck vermitteln, dass Statistik mit dem wirklichen Leben nichts zu tun hat. Viel besser wäre es, Statistik mit echten Problemen und anhand konkreter Fälle zu vermitteln. So könnten Schüler im Kunstunterricht etwa lernen, dass Infografiken auch lügen können. Im Deutsch- und Englischunterricht könnten sie lernen, anhand von KI-basierten Textanalysen Falschmeldungen zu entlarven. Würden diese Grundlagen gelegt, hätten wir weniger zahlenblinde Mediziner, Politiker und Journalisten.

Über die Autoren

Thomas Bauer ist Professor für empirische Wirtschaftsforschung, Gerd Gigerenzer Direktor des Harding-Zentrums für Risikokompetenz der Universität Potsdam. Walter Krämer ist emeritierter Professor für Wirtschafts- und Sozialstatistik und Katharina Schüller Geschäftsführerin und Gründerin der Statistikberatung Stat-up.

Dieses Dokument ist für den persönlichen Gebrauch bestimmt.

Kommentar abgeben

vielen Dank für Ihren Hinweis. Die Formulierung «in der Folge» beinhaltet in der Tat keinen zeitlichen Rahmen und ist damit ungenau. Im Buch befindet sich eine Grafik von Gerd Gigerenzer, die die Anzahl der Todesopfer im amerikanischen Strassenverkehr in den Monaten vor und nach dem Attentat als Abweichung vom Durchschnitt der Jahre 1996 bis 2000 zeigt. Darin ist ersichtlich, dass es vor dem Attentat keine Auffälligkeiten gab, die Todeszahlen danach allerdings ein Jahr lang über dem Durchschnitt lagen. Erst dann fielen die Zahlen wieder zurück auf den Stand vor dem Attentat. In dieser Zeit sind Schätzungen zufolge 1600 Verkehrsteilnehmer mehr gestorben, als ohne Terroranschlag zu erwarten gewesen wäre. Diese Zahlen sind nachzulesen in Gerd Gigerenzers Buch «Risiko» von 2013. Um aber künftige Missverständnisse zu vermeiden, passen wir die Stelle im Abstract an. Vielen Dank!

Freundliche Grüße

Belén Haefely aus der Redaktion